Micron Technology Ai Benefits Questioned – Baru -baru ini, tim Micron menunjukkan monumen AI dan penyimpanan NVIDIA GTC. Blog ini mengambil beberapa detail produk kepemimpinan AI yang membawa konsentrasi dan kegembiraan peserta pameran dan peserta. Saya sudah mempelajari bagaimana memori Micron tidak hanya memungkinkan masa depan AI, tetapi juga mengubahnya.

Kami dikukuhkan untuk dunia di mana digital dan tubuh Les tidak hanya kabur – mereka sangat lega. Di masa depan ini, kita akan ditekankan tidak hanya oleh kekuatan CPU dan GPU, tetapi juga pahlawan teknologi semikonduktor: catatan dan chip penyimpanan. Bersama -sama, perangkat ini adalah percepatan tulang punggung penulisan buatan (AI), kekuatan memutar sepeda AI untuk menjadikannya bagian dari kehidupan kita sehari -hari. Secara khusus, memori bertindak sebagai darah AI, memungkinkannya belajar dari database besar, dan membuat masa depan bekerja dengan teknologi lebih indah, mulus dan bertekad untuk palsu.

Micron Technology Ai Benefits Questioned

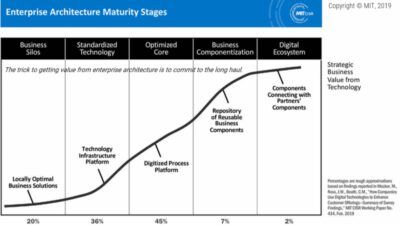

Ekonomi di seluruh dunia adalah pengalaman menumbuhkan adrenala novasi dan konsumsi. Mengembangkan mikron dari teknologi 232 kolom pertama, LEADG-MAKALI 1ß (1-beta) Micron HBM3E NVIDIA: N H200-TENSOR-GPUS-GPU GPU GPU GPU Micron H200-Tensor-GPU. Setiap novenation dan pembiakan sampul Micron AI memberi kita selangkah lebih dekat ke dunia di mana AI mempercepat realitas palsu palsu, fajar di mana monumen tersebut menjadi dasar revolusi AI.

Micron’s 176-layer Technology Offers Breakthrough In Performance

Catatan dan semikonduktor adalah hambatan untuk pembangunan perubahan ini, yang mempromosikan lingkungan di mana AI tidak hanya benar tetapi juga membaik. Perjalanan ini melalui jalan -jalan novasi menunjukkan bagaimana teknik -teknik ini memiliki batas AI pushg. Dengan memahami peran penting mereka, kami berdiri di masa depan BRK, di mana kemampuan teknologi terbatas pada ide -ide kami.

Jadi mengapa saya menulis blog ini? Saya telah mendapat hak istimewa untuk Pasar Perusahaan LEAR Micron selama 20 bulan, ditandai dengan memulai produk kerusakan lainnya dengan mempercepat AI. Bekerja dengan buatan tangan, pengecer, penyelenggara, dan manajer bus, kelompok saya dan saya telah berada di garis depan, peluncuran dan diskusi tentang diskusi di sekitar mereka. Perjalanan ini telah menjadi hari yang mungkin di seluruh dunia dan teknologi mikron dari Marketg dan Narratg’s Narratg Story di seluruh dunia.

Keandalan buatan, instruksi memori dan penyimpanan bukan hanya tentang menambahkan GPU dan CPU – tulang belakang mengurangi fitur dan fitur AI. Memori dekat berada di arah ini yang teknologinya menunjukkan solusi sebagai solusi untuk bandwidth tertinggi (HBM), HBM3E. Memori ini hampir memungkinkan AI untuk melakukan perhitungan yang kompleks dan memproses sejumlah besar informasi dan efisiensi yang tidak biasa, penting untuk menganalisis waktu aktual dan membuat pengambilan keputusan.

Piramida descentg, kami menghadapi memori MA, pada dasarnya berisi produk -produk seperti DDR5 DIMM monolitik tinggi Micron. Kolom ini berfungsi sebagai tugas penting dari perhitungan AI, memberikan kecepatan yang tidak seimbang dan kemampuan untuk mengontrol informasi terperinci yang perlu dianalisis oleh algoritma AI. Pengembangan dan efisiensi daya mikron kecepatan DDR5 menyediakan platform yang kuat untuk sistem operasi AI, yang mendukung implementasi waktu dan model simulasi yang cepat.

Everything You Wanted To Know About Ai But Were Afraid To Ask!

Kecepatan memori ekspansi mengurangi solusi negatif, seperti Micron’s CZ120, yang menggunakan Compute Express LK ™ (CXL ™) dan dirancang untuk memperluas fitur memo sistem di luar batas tradisional. Kolom ini menjelaskan persyaratan pertumbuhan untuk penggunaan memori AI, memungkinkan model yang komprehensif dan lebih kompleks untuk diimplementasikan dan diimplementasikan. Ini menunjukkan dasar penting untuk memberi tahu pembatasan arsitektur tubuh – dan memberi AI kemampuan untuk meningkatkan fitur mereka tanpa mengorbankan kinerja.

Saat kami pindah ke instruksi memori dan penyimpanan, cache data SSD merupakan solusi penghematan gudang penting yang menyediakan akses langsung ke informasi yang digunakan secara teratur. Level ini mempercepat proses restorasi data dengan memastikan bahwa penggunaan AI dapat beroperasi tanpa menunda penyebab ketersediaan informasi. Aplikasi SSD LEADG Micron seperti 9000 dan 7000 kolom, contoh seberapa cepat penyimpanan LeverAgg dapat secara signifikan meningkatkan sensitivitas dan efisiensi AI.

Di bagian bawah piramida, ada lapisan penyimpanan informasi dasar. Ini adalah set besar data mentah yang membagi algoritma AI menjadi trag dan analisis. Kemampuan untuk menyimpan dan mengelola informasi ini sangat diperlukan untuk pengembangan AI, yang merupakan pentingnya solusi berkualitas tinggi, karena kolom 6000 SSD Micron memfasilitasi peningkatan lingkungan informasi AI. Penyimpanan Hard Drive SPNG (HDD) telah lama selesai.

Bersama -sama, lapisan -lapisan ini membentuk struktur terintegrasi yang melewati revolusi AI, dengan fokus pada peran terbarukan dari teknologi memori dan penyimpanan. Micron’s Broth-Nolls dalam kepemimpinan ini memberi kita kesempatan untuk memahami bagaimana setiap level mempromosikan AI secara unik. Diberi bersama, pawai ini dapat membuat rekan AI dan lebih banyak kehidupan digital kita.

Micron Technology: Nothing Is Over (nasdaq:mu)

HBM3E Micron dimanifestasikan sebagai mercusuar untuk memori terdekat, kecepatan menyediakan dan efisiensi yang diperlukan untuk model bahasa besar (LLM) dan penggunaan AI. Dengan memberi tahu memori, HBM3E memberikan sistem AI untuk lebih dekat dengan kinerja prosesor teratas mereka, yang sangat penting karena piksel LLMS dan basis data mereka tumbuh sangat.

Kabel Mikron Stasiun ini ditekankan oleh komitmen kami untuk mendorong kapasitas memori dan bandwidth dan solusi sebagai konfigurasi maksimum 24GB dan 12GB 12GB dan efisiensi energi semikonduktor. Micron HBM3E membuat AI lebih terbuka, karena dibandingkan dengan pesaing dibandingkan dengan pesaing, saya bisa sangat penting.

Pembuatan HBM3E di pasaran, terutama fleksibilitasnya di H200 -tensor NVIDIA di GPU, berarti kinerja tinggi. Lompatan ini berarti mempromosikan inti AI dan menyediakan jalur energi terbaik untuk mempercepat AI. Micron HBM3E adalah titik penggunaan AI untuk model yang lebih besar secara lebih efisien, Heraldg di masa depan, di mana AI dapat berkembang tanpa batasan pada pembatasan memori saat ini. Kapasitas ini juga mengarah pada biaya operasi dan dampak lingkungan dari pusat data.

Konsumsi daya rendah di pasar mikron HBM3E sangat penting untuk masa depan stasiun informasi AI besar. Konsentrasi pada generasi LEAPG ini menunjukkan bahwa pendekatan depan-tykg memenuhi persyaratan penelitian dan waktu pengembangan AI selama daya tahan dan kinerja yang efektif selama efektivitas biaya. HBM3E Solusi Mikron Tegratg yang kuat dapat menghemat biaya kinerja tinggi untuk pusat data yang ditargetkan AI. Savg ini penting karena penggunaan sumber daya kinerja tinggi adalah biaya pekerjaan tinggi. Efisiensi energi utama dari penyedia layanan cloud besar dapat secara dramatis mengurangi penggunaan biaya listrik dan operasi, yang penting untuk pentingnya memilih teknologi memori untuk struktur AI mereka.

Micron Stock Looks Like ‘dead Money’ Heading Into Report

Selain itu, langkah strategis menuju praktik berkelanjutan yang tampaknya berfokus pada kondisi yang lebih luas dengan mengurangi dampak lingkungan dari fungsi komputasi yang besar. Teknologi memori pengembangan mikron tidak hanya memungkinkan tingkat perhitungan yang diperlukan untuk mempercepat AI, tetapi juga menunjukkan bagaimana teknologi teknologi dapat sejalan dengan tujuan lingkungan.

Perubahan ini menunjukkan penekanan pada tarian untuk kinerja yang salah dan efisiensi serta daya tahan kekuasaan. Kami juga merupakan sampel HBM3E 36 GB 12-tinggi, yang memfasilitasi kapasitas tertinggi platform AI. Micron HBM adalah struktur AI evolvg pahlawan pahlawan, di mana teknologi teknologi mengisi struktur hati nurani untuk mempromosikan masa depan AI.

Memori DDR5 MA Micron Micron Micron adalah bagian integral dari sifat proses AI dengan memberikan kecepatan dan Shapg yang tidak seimbang dan efektif di masa depan di masa depan AI. 128 GB DDR5 RDIMMS mempercepat hingga 8.000 mb/s dan mengambil simpul mikron berkualitas tinggi di lebih dari 45%. Perkembangan ini – mewakili kinerja dan efisiensi energi yang efektif – sangat penting untuk menganalisis dan memproses data AI. Ini juga meningkatkan kecepatan dan pengambilan keputusan sistem AI dengan 17 %rendah.

Untuk meningkatkan sistem ekologis, produk LPDDR5X dan LPCAMM2 Micron meningkatkan kecepatan ini. LPDDR5X menggantikan pendahulunya dan 12% dengan mengurangi daya sebesar 30% hingga 9,6 GB/s, yang didedikasikan untuk mikron, yang mengarah ke memori daya rendah yang mengarah. Micron LPCAMM2, di sisi lain, mengambil memori baru dari Paradigma MA ke komputer dan pusat data AI. Ini menawarkan kecepatan hingga 9600 mb/s dan secara signifikan mengurangi konsumsi daya, yang memfasilitasi perhitungan AI yang lebih baik dan kuat karena bentuk standar.

A World’s First On-glass Genai Demonstration: Qualcomm’s Vision For The Future Of Smart Glasses

Lebih banyak Mikron Pengembangan DDR5 dan LPDDR5X dan Modul memori LPCAMM2 menunjukkan pertemuan besar tentang persyaratan pekerjaan AI dan mache. Teknik -teknik ini memberikan peningkatan kecepatan, efisiensi, dan berkurangnya konsumsi daya, fitur yang penting untuk memimpin penyedia layanan cloud di seluruh dunia.

Dinasti Saat pusat data tersedia berdasarkan